MS Azure Data Factory

Im Data Engineering mit der Microsoft Azure Data Factory (ADF) bieten wir eine Vielzahl von Dienstleistungen zur Verwaltung und Verarbeitung von Daten an. Diese Services umfassen das gesamte Spektrum der Datenintegration, von der Extraktion bis zur Transformation und zum Laden (ETL/ELT).

Daten-Integration

Verbindung zu mehreren Datenquellen

Wir erstellen Pipelines, um Daten aus verschiedenen Quellen zu extrahieren, sowohl On-Premises als auch in der Cloud. Dazu gehören SQL-Datenbanken, NoSQL-Datenbanken, APIs, Dateispeicher wie Azure Blob Storage oder Drittanbieterquellen wie Amazon S3.

Hybride Datenverarbeitung

Mit der Integration Runtime ermöglichen wir die Verarbeitung von Daten, unabhängig davon, ob sie lokal oder in der Cloud gespeichert sind.

ETL- und ELT

Datenextraktion (Extract)

Wir extrahieren Daten aus Quellsystemen und bereiten sie für die Weiterverarbeitung vor. Dies kann regelmäßig oder ereignisgesteuert erfolgen.

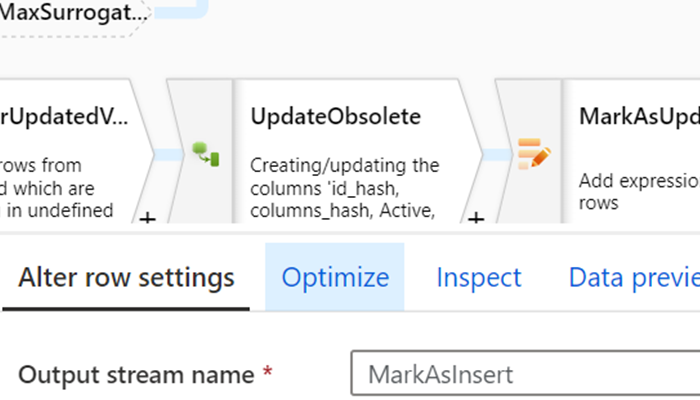

Datenumwandlung (Transform)

Wir transformieren die Rohdaten, indem wir Berechnungen durchführen, Daten validieren, bereinigen, aggregieren und für die Analyse vorbereiten. Dies erfolgt oft über Mapping Data Flows in ADF.

Datenladen (Load)

Die transformierten Daten laden wir in Zielsysteme wie Data Warehouses, Data Lakes (z. B. Azure Data Lake) oder Reporting-Systeme.

Automatisierung

Erstellung von Daten-Pipelines

Wir erstellen und verwalten Pipelines, die Datenflüsse zwischen verschiedenen Prozessen orchestrieren. Dabei konfigurieren wir Aktivitäten, bedingte Ausführungen und Verzweigungen in den Pipelines.

Automatisierung von Workflows

Durch die Verwendung von Triggern automatisieren wir Pipelines, sodass sie zeitgesteuert oder ereignisabhängig ausgeführt werden.

Fehler-Behandlung

Wir implementieren Mechanismen zur Fehlerbehandlung, um sicherzustellen, dass Prozesse bei Problemen sicher gestoppt oder wiederhergestellt werden können.

Daten-Migration

Migration von On-Premises zu Cloud

Wir unterstützen bei der sicheren und effizienten Migration von Daten aus lokalen Systemen in die Cloud, indem wir ADF für die Übertragung und Transformation verwenden.

Datenverschiebung zwischen Cloud-Diensten

Mithilfe von Azure Data Factory verschieben wir Daten zwischen verschiedenen Cloud-Diensten, z. B. von Amazon S3 zu Azure Blob Storage oder zwischen verschiedenen Azure-Diensten.

Daten-Aufbereitung für Machine Learning

Vorverarbeitung von Daten für ML

Wir bereiten Daten für Machine-Learning-Modelle vor, indem wir sie bereinigen, formatieren und aggregieren, oft in Kombination mit Azure Machine Learning.

Automatisierung von ML-Daten-Pipelines

Wir automatisieren Datenpipelines, um kontinuierlich aktualisierte Daten für Machine Learning bereitzustellen.

Data Governance und Sicherheit

Kontrolle des Datenzugriffs

Wir implementieren Sicherheitsrichtlinien, um den Zugriff auf sensible Daten zu kontrollieren und sicherzustellen, dass nur autorisierte Personen auf bestimmte Datenpipelines und -quellen zugreifen können.

Compliance und Auditing

Wir stellen sicher, dass alle gesetzlichen Vorschriften eingehalten werden, indem wir Protokolle über Datenbewegungen und -transformationen bereitstellen.

Kontaktieren Sie uns für Projekte in Deutschland, Österreich und der Schweiz.

Fähigkeiten

Die Microsoft Azure Data Factory (ADF) ist ein cloudbasierter Dienst zur Integration von Daten, der es Unternehmen ermöglicht, Daten aus verschiedenen Quellen zu verbinden, zu transformieren und zu verwalten.

Datenintegration

ADF ermöglicht das Sammeln und Integrieren von Daten aus verschiedenen Quellen, wie Datenbanken, APIs, Dateisystemen oder Cloud-Diensten (z. B. Azure Blob Storage, SQL Server, Salesforce, Amazon S3)

ETL/ELT-Prozesse

Azure Data Factory bietet Tools für ETL (Extract, Transform, Load) und ELT (Extract, Load, Transform)-Prozesse.

Es ermöglicht das Extrahieren von Daten aus verschiedenen Quellen, deren Transformation (z. B. Datenbereinigung, Berechnungen) und das Laden in Ziele wie Data Warehouses oder Data Lakes.

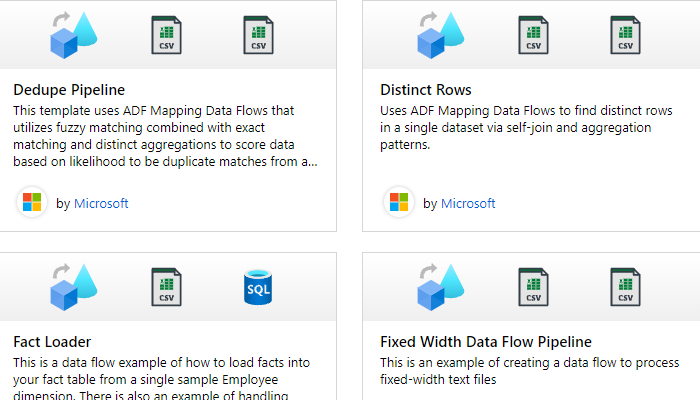

Daten-Orchestrierung

ADF bietet eine visuelle Oberfläche, mit der Benutzer Datenpipelines erstellen können. Pipelines bestehen aus Aktivitäten und Verknüpfungen, die Daten extrahieren, transformieren und laden.

Data Flow und Transformationen

Mit Mapping Data Flows in ADF können komplexe Transformationen ohne manuelles Schreiben von Code erstellt werden. Es bietet eine drag-and-drop-Oberfläche zum Entwerfen von Datenflussprozessen.

Skalierbarkeit und Leistungsfähigkeit

ADF kann große Datenmengen effizient verarbeiten und ist skalierbar, um sich dynamisch an wechselnde Datenanforderungen anzupassen. Es nutzt die Leistung der Azure Cloud für die parallele Datenverarbeitung.

Automatisierung und Zeitplanung

Pipelines können automatisiert werden, um in geplanten Intervallen oder als Reaktion auf bestimmte Ereignisse ausgeführt zu werden.